GLM‑4.6 là gì? Có gì mới so với 4.5?

“Flagship” mới của Z.ai (tiền thân Zhipu AI), tập trung 3 mảng: reasoning, coding, agent.

Điểm nâng cấp chính thức so với GLM‑4.5:

Context: 128K → 200K.

Coding: điểm benchmark và trải nghiệm thực tế tốt hơn, đặc biệt khi làm UI front‑end và các IDE/agent như Claude Code, Cline, Roo Code, Kilo Code.

Reasoning: cải thiện suy luận và hỗ trợ tool‑use ngay trong quá trình suy nghĩ.

Agent: tích hợp framework agent tốt hơn, hỗ trợ search‑based agents mượt hơn.

Style viết tự nhiên hơn (alignment tốt hơn cho role‑play, văn phong “người”). Z.ai Research – GLM‑4.6 • Hugging Face – GLM‑4.6

Tham khảo trang model chính thức và docs:

Z.ai Research – GLM‑4.6: Bài blog công bố

Z.ai Developer Docs – GLM‑4.6: Overview, Quick Start, Pricing, SDK

Hugging Face – GLM‑4.6: zai‑org/GLM‑4.6

Thông số và tính năng chính (từ nguồn chính chủ)

Cửa sổ ngữ cảnh: 200K token.

Chế độ suy nghĩ + tool‑use trong lúc suy luận.

Tối ưu cho coding và tác vụ đa bước của agent.

Dùng chung phương thức suy luận với 4.5, nên pipeline tích hợp không phải viết lại từ đầu nhiều. Z.ai Developer Docs • Hugging Face – GLM‑4.6

Nếu bạn cần open‑weights để tự host/on‑prem: tham khảo GLM‑4.5 và GLM‑4.5‑Air (MIT). Hugging Face – GLM‑4.5 • Z.ai Research – GLM‑4.5

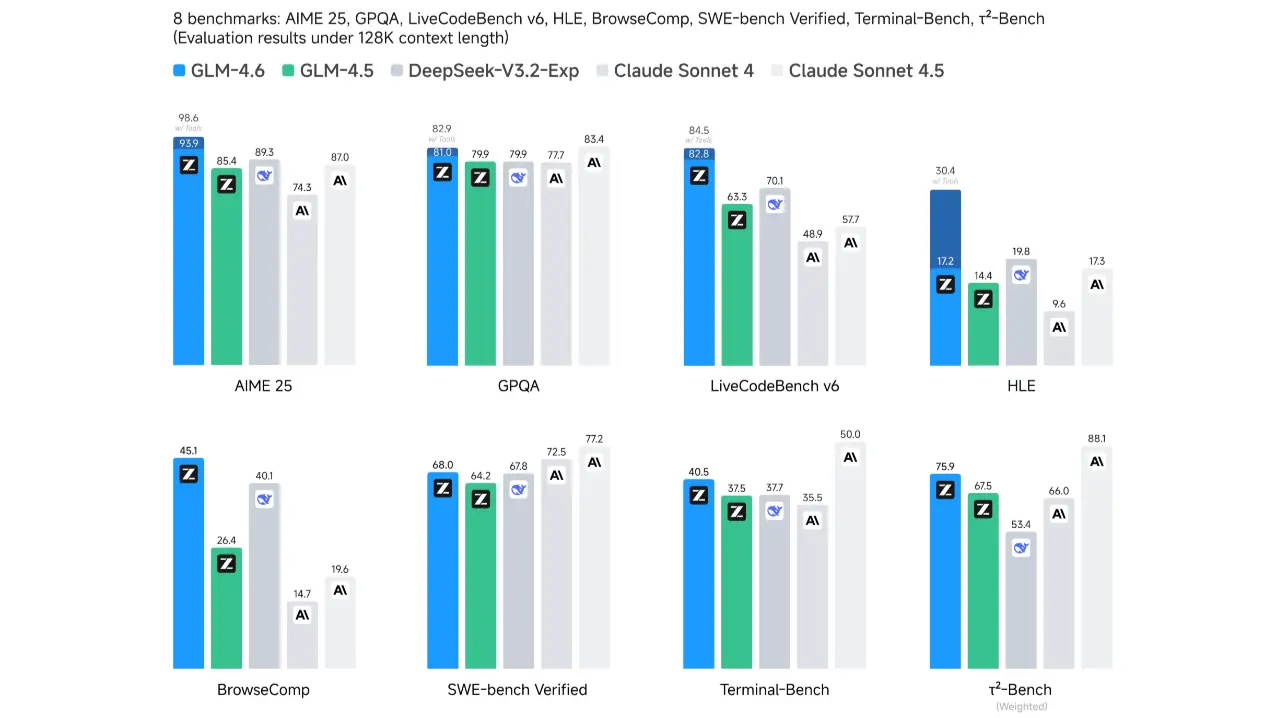

Benchmark và trải nghiệm thực tế

Z.ai cho biết 4.6 nâng điểm trên 8 benchmark công khai về agents, reasoning, coding và vượt 4.5 ở hầu hết hạng mục; một số so sánh còn đề cập lợi thế trước vài model nội địa và quốc tế ở tác vụ cụ thể, nhưng coding vẫn có ngách nơi Claude bản mới mạnh hơn. Tóm lại: 4.6 “thực chiến” hơn 4.5, đặc biệt khi kèm tool‑use. Z.ai Research – GLM‑4.6

OpenRouter tổng hợp thông tin chung của 4.6, nhấn mạnh 200K context và cải thiện coding/agent; tiện theo dõi tình trạng provider, uptime, route khi bạn tích hợp đa nhà cung cấp. OpenRouter – GLM‑4.6

Lưu ý: leaderboard chỉ là một phần. Hãy test trên bài toán của bạn (repo thật, log thật, data thật) để có kết luận phù hợp scenario của team.

Nguồn tham khảo tổng hợp, để bạn tự đối chiếu thêm:

Z.ai Developer Docs – GLM‑4.6: Overview, Quick Start, Pricing, SDK

Z.ai Research – GLM‑4.6: Bài blog công bố

OpenRouter – GLM‑4.6: Trang model, route và giá tham khảo

Z.ai Research – GLM‑4.5: Bài blog kỹ thuật

Gọi GLM‑4.6 như thế nào?

Có 3 hướng phổ biến:

Gọi thẳng qua Z.ai API Platform: xem Quick Start, Pricing, SDK trong Docs. Z.ai Developer Docs

Đi qua OpenRouter: tiện “route” nhiều provider, theo dõi uptime, đổi đường khi context lớn. OpenRouter – GLM‑4.6

Hệ sinh thái Trung Quốc/Mainland: tham khảo BigModel/Open Platform các dòng GLM khác (GLM‑4‑Plus, GLM‑4‑Long…) nếu bạn target thị trường đó. ZHIPU AI Open Platform

Code mẫu cơ bản (pseudo‑JS, minh họa payload messages):

const resp = await fetch("<https://openrouter.ai/api/v1/chat/completions>", {

method: "POST",

headers: {

"Content-Type": "application/json",

"Authorization": `Bearer ${process.env.OPENROUTER_API_KEY}`

},

body: JSON.stringify({

model: "z-ai/glm-4.6",

messages: [

{ role: "system", content: "You are a helpful assistant." },

{ role: "user", content: "Phân tích repo này và đề xuất plan refactor." }

],

temperature: 1.0

})

});Tham số gợi ý: giữ temperature 1.0 cho đánh giá tổng quát như docs khuyến nghị của GLM. Hugging Face – GLM‑4.6

Use case gợi ý mình thấy “thơm” với 4.6

Code assistant đa tệp: yêu cầu refactor module cũ, sinh test, check convention, đề xuất patch tối thiểu.

Agent nhiều bước: tạo tính năng CRUD end‑to‑end, sinh file + route + test, bạn duyệt từng diff.

Đọc dự án/log dài: tóm tắt, tìm “hot path”, đề xuất tối ưu query/cache.

Tạo UI nhanh: “wireframe → UI HTML/CSS/JS” để prototype nhanh rồi tinh chỉnh bằng tay.

Mẹo tối ưu chất lượng khi gọi 4.6

Viết Project Brief/Rules rõ ràng: stack, coding style, kiến trúc, limit tác động của agent.

Ràng buộc output: yêu cầu diff/patch, kèm đường dẫn file.

Chia nhỏ việc: “đề xuất → duyệt → áp dụng → test”.

Quản lý context: cắt ghép input hợp lý để không lãng phí 200K token vô ích.

FAQ nhanh

4.6 có open‑weights không?

Hiện trang chính thức tập trung API và thông số nâng cấp. Nếu bạn cần open‑weights để tự host, hãy dùng nhánh 4.5/4.5‑Air (MIT) trên Hugging Face. Hugging Face – GLM‑4.5

Giá gọi qua Z.ai là bao nhiêu?

Check trực tiếp mục Pricing trên Docs và nhà cung cấp bạn chọn. Nếu đi qua OpenRouter sẽ có bảng giá theo provider tuyến tính theo thời điểm. Z.ai Developer Docs • OpenRouter – GLM‑4.6

Context 200K đủ để “nuốt” cả codebase chưa?

Tùy repo. 200K rất thoải mái cho nhiều dự án, nhưng vẫn nên chọn lọc vùng liên quan để tăng độ chính xác và tốc độ.

Kết luận

Nếu bạn đang build agent/code assistant và cần context lớn, 4.6 cho trải nghiệm “nắm việc” hơn 4.5 rõ rệt, đặc biệt khi kết hợp tool‑use. Còn nếu hạ tầng yêu cầu tự host, kiểm soát tuyệt đối, GLM‑4.5/4.5‑Air open‑weights vẫn vô đối về sự linh hoạt.